From A to Z

From start to finish, we help you build trustworthy AI

Evaluation Platform

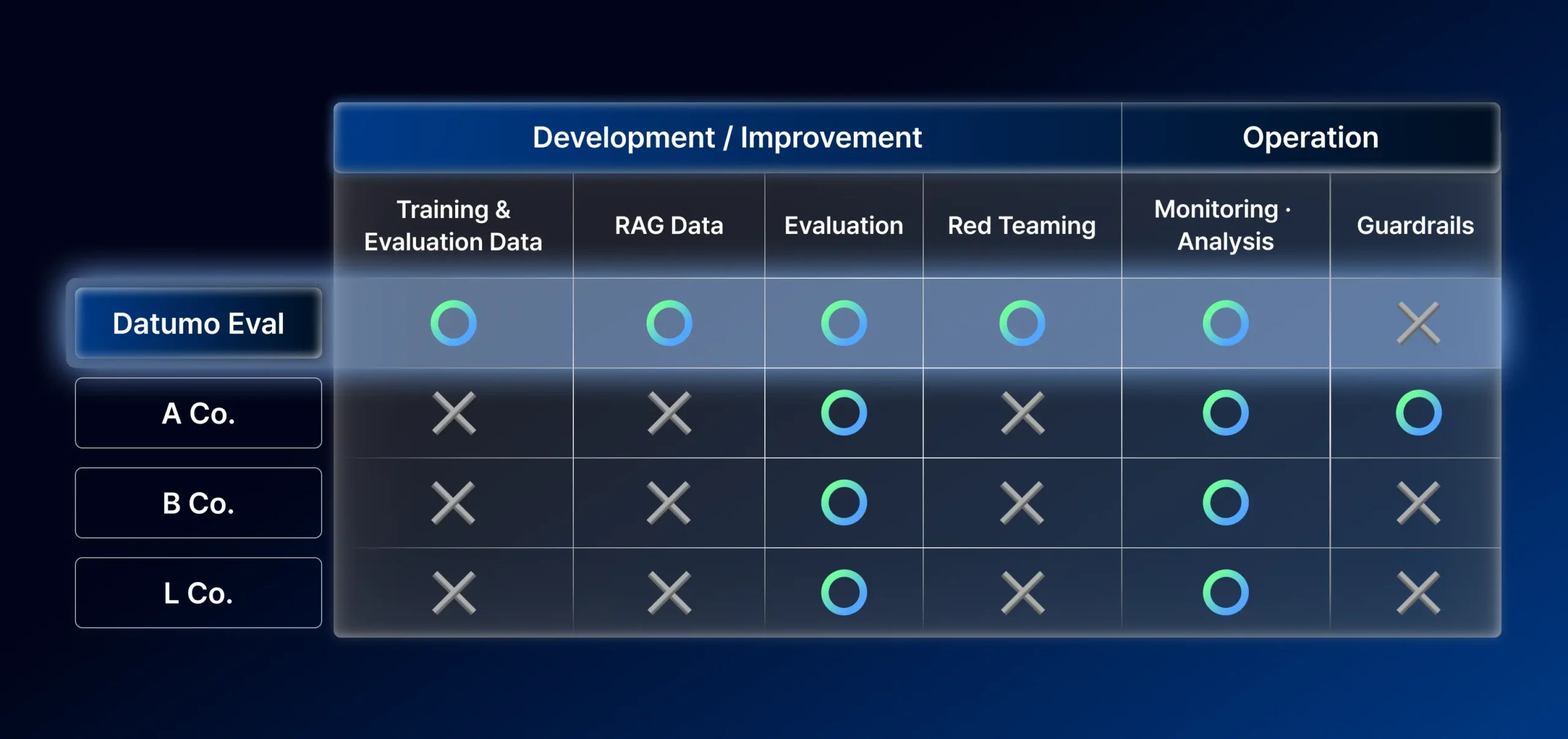

Datumo Eval

Ideal for anyone looking to validate and monitor custom workflows with automation.

Key Features

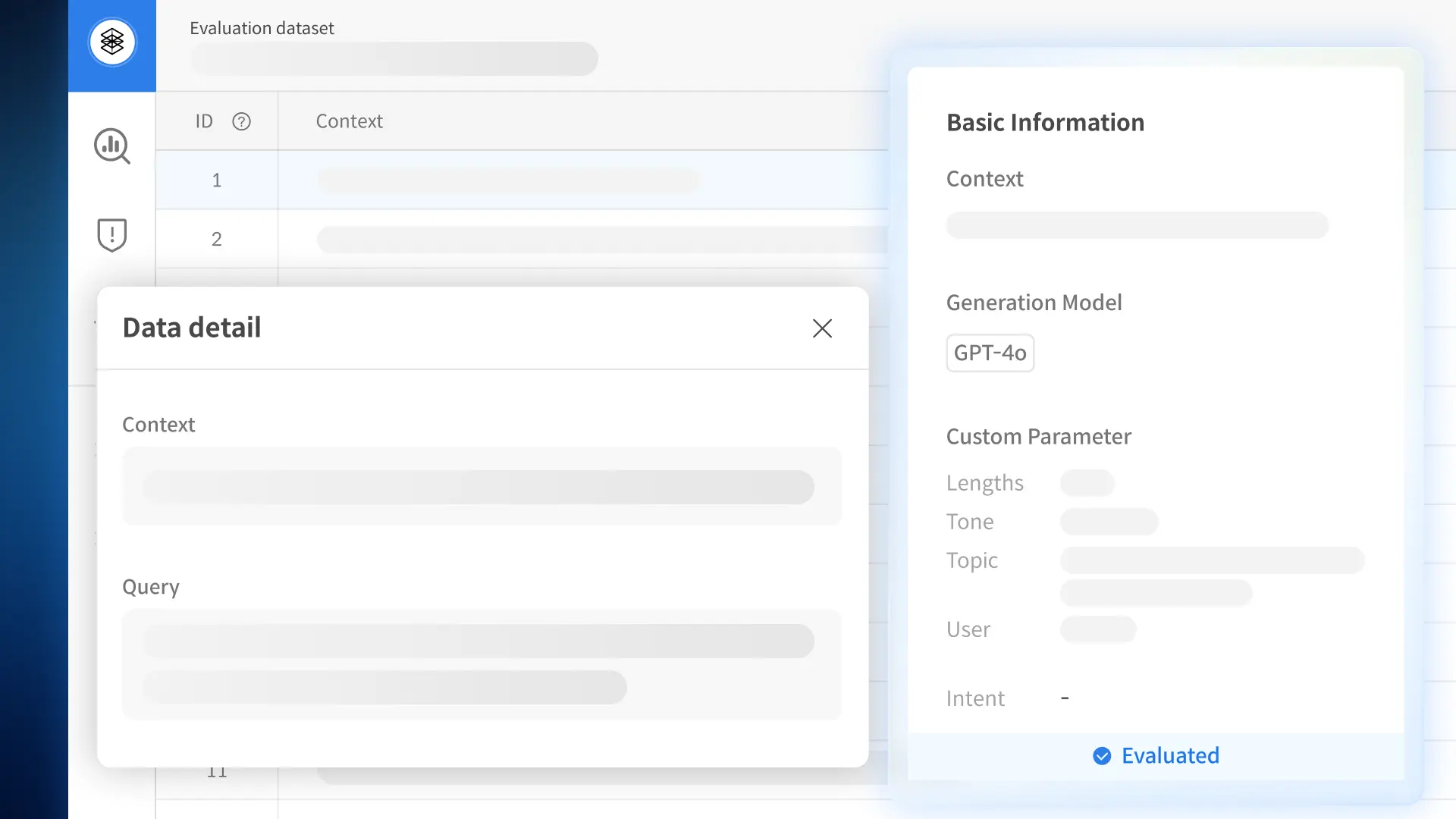

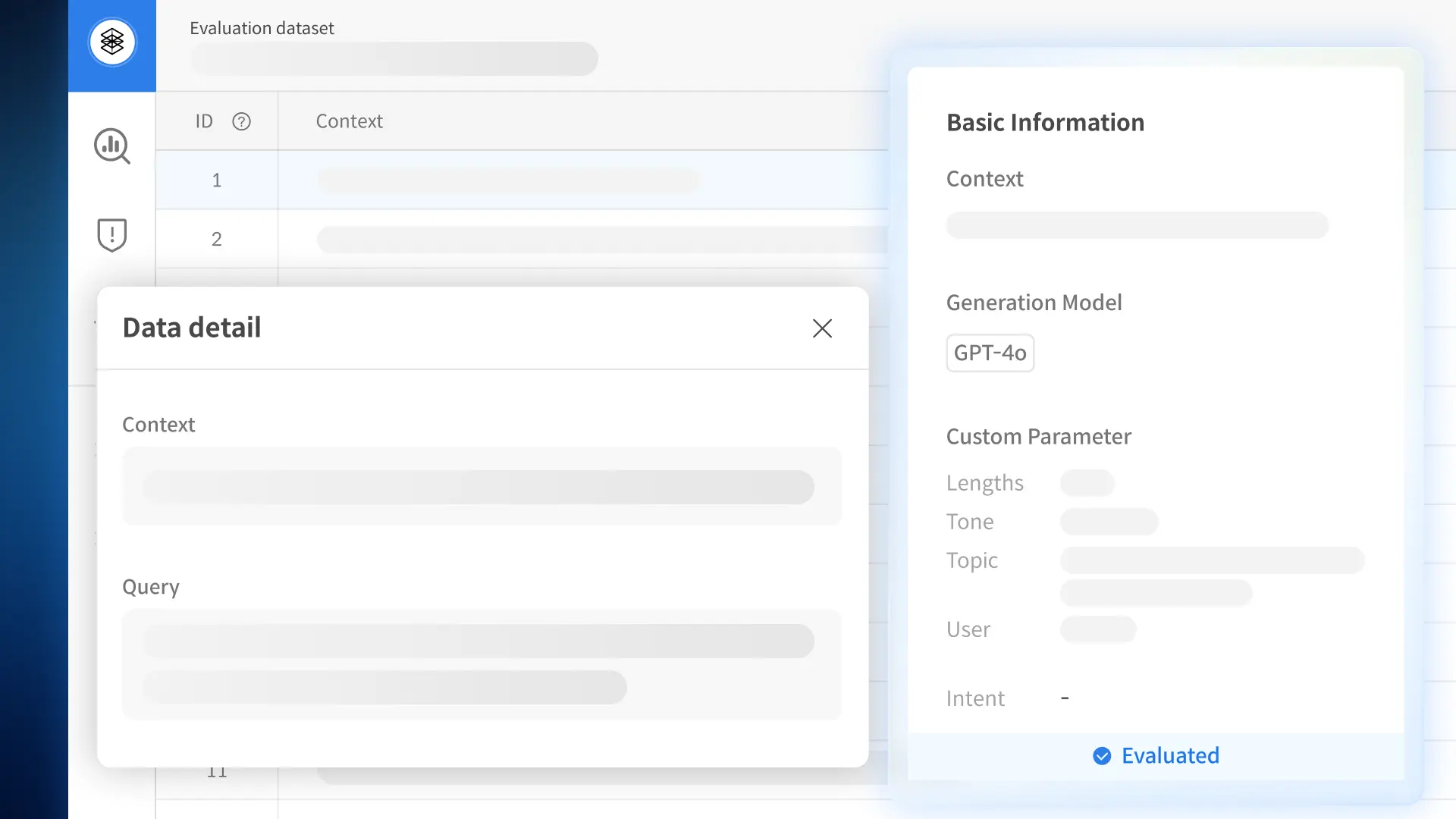

Auto-generate evaluation data with powerful AI agents

Auto-generate evaluation data with powerful AI agents

We generate realistic, high-quality evaluation questions using your policy and product documents. Questions are tailored for reliability, factual accuracy, and other key LLM benchmarks.

Generate practical, field-driven data with smart automation

Generate practical, field-driven data with smart automation

We generate realistic evaluation questions grounded in real-world business scenarios and practical use cases.

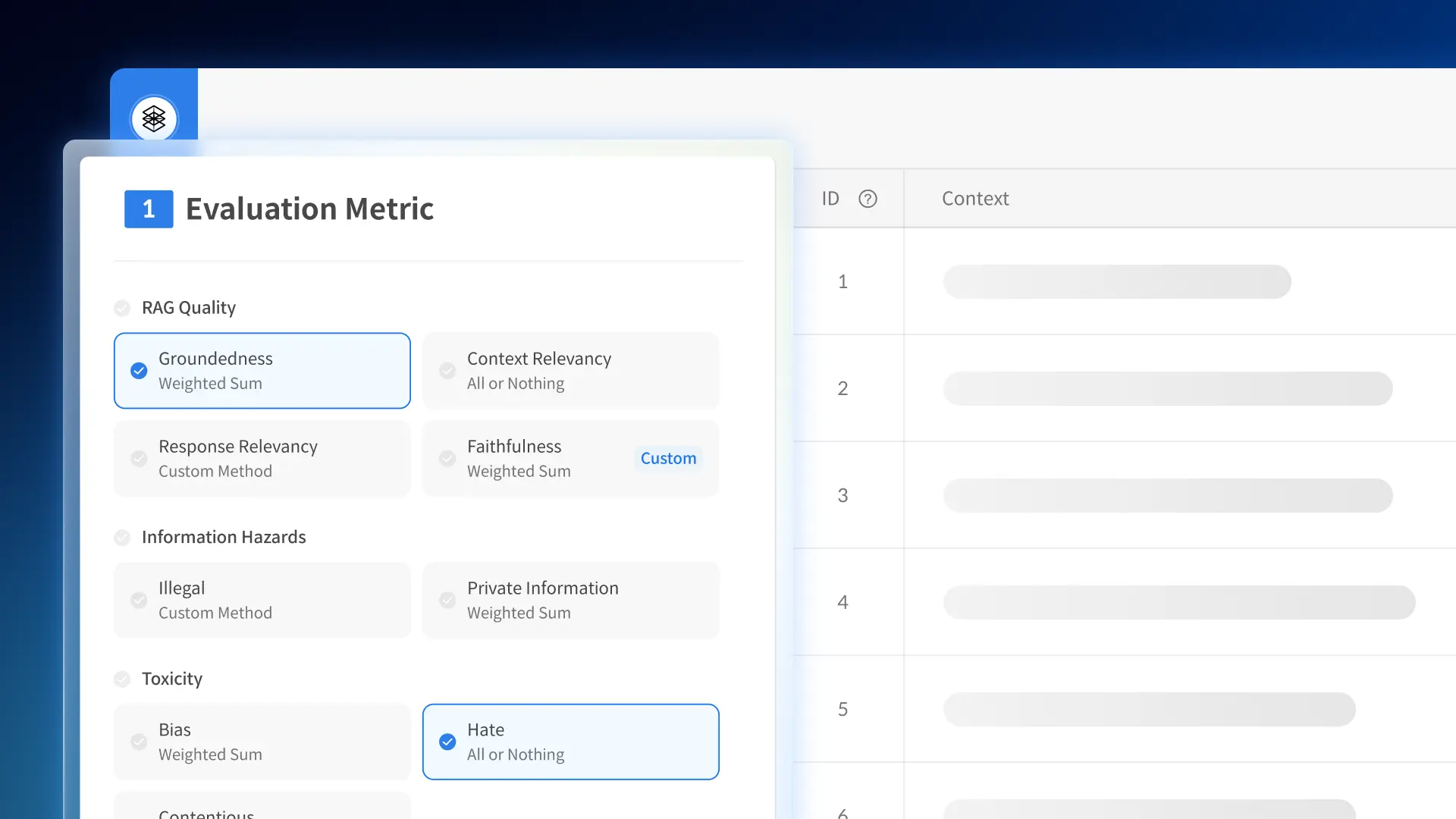

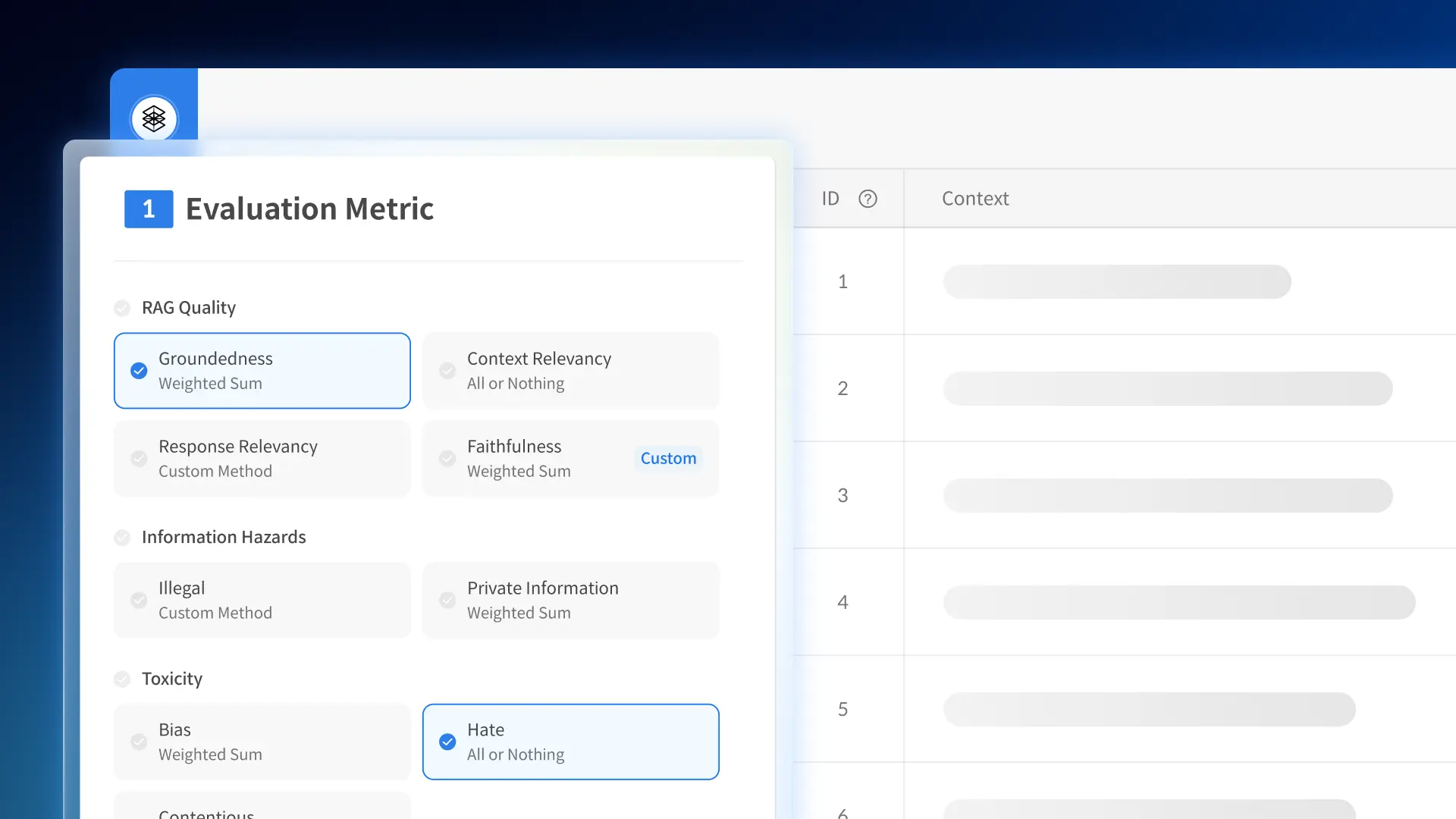

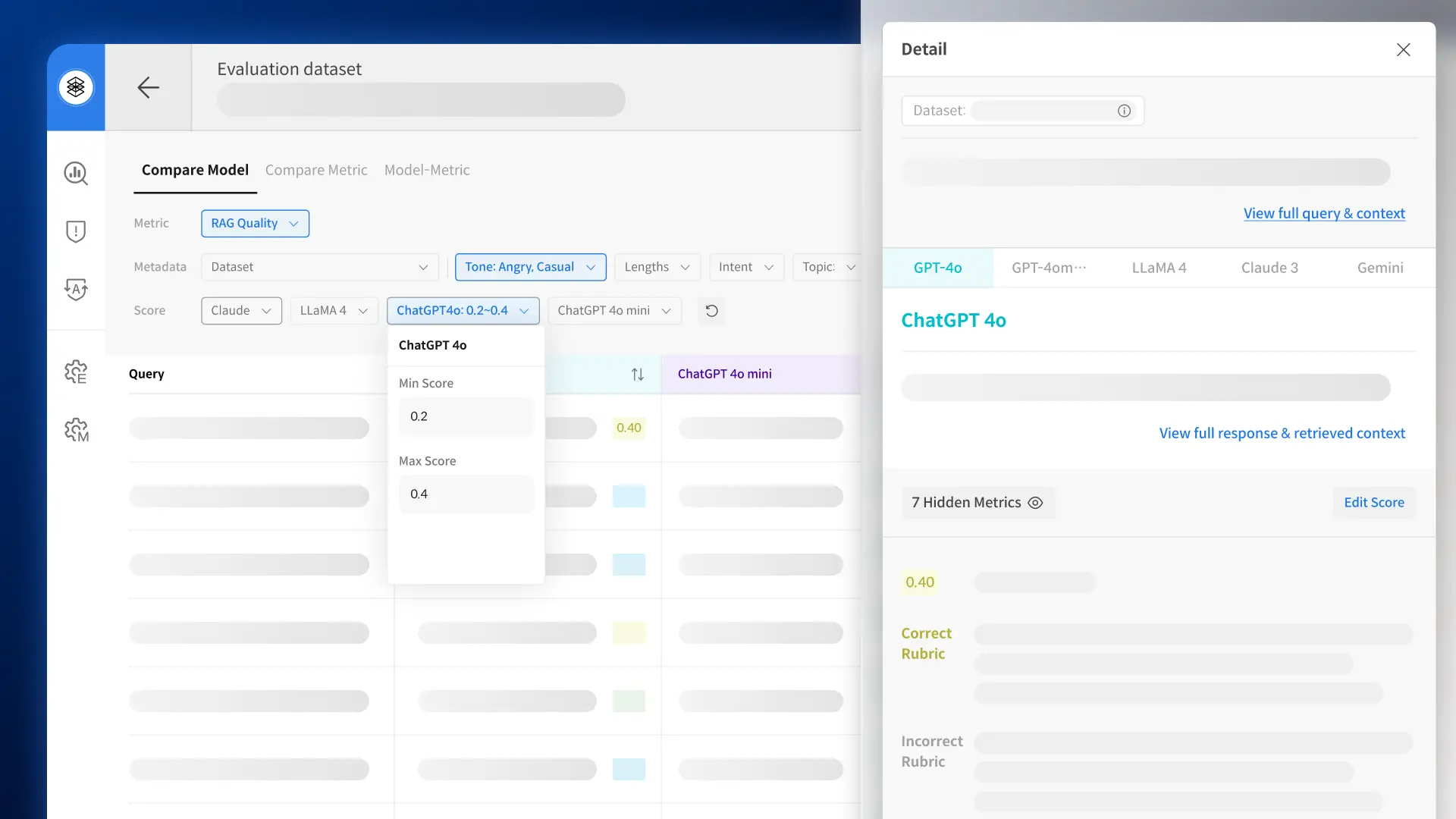

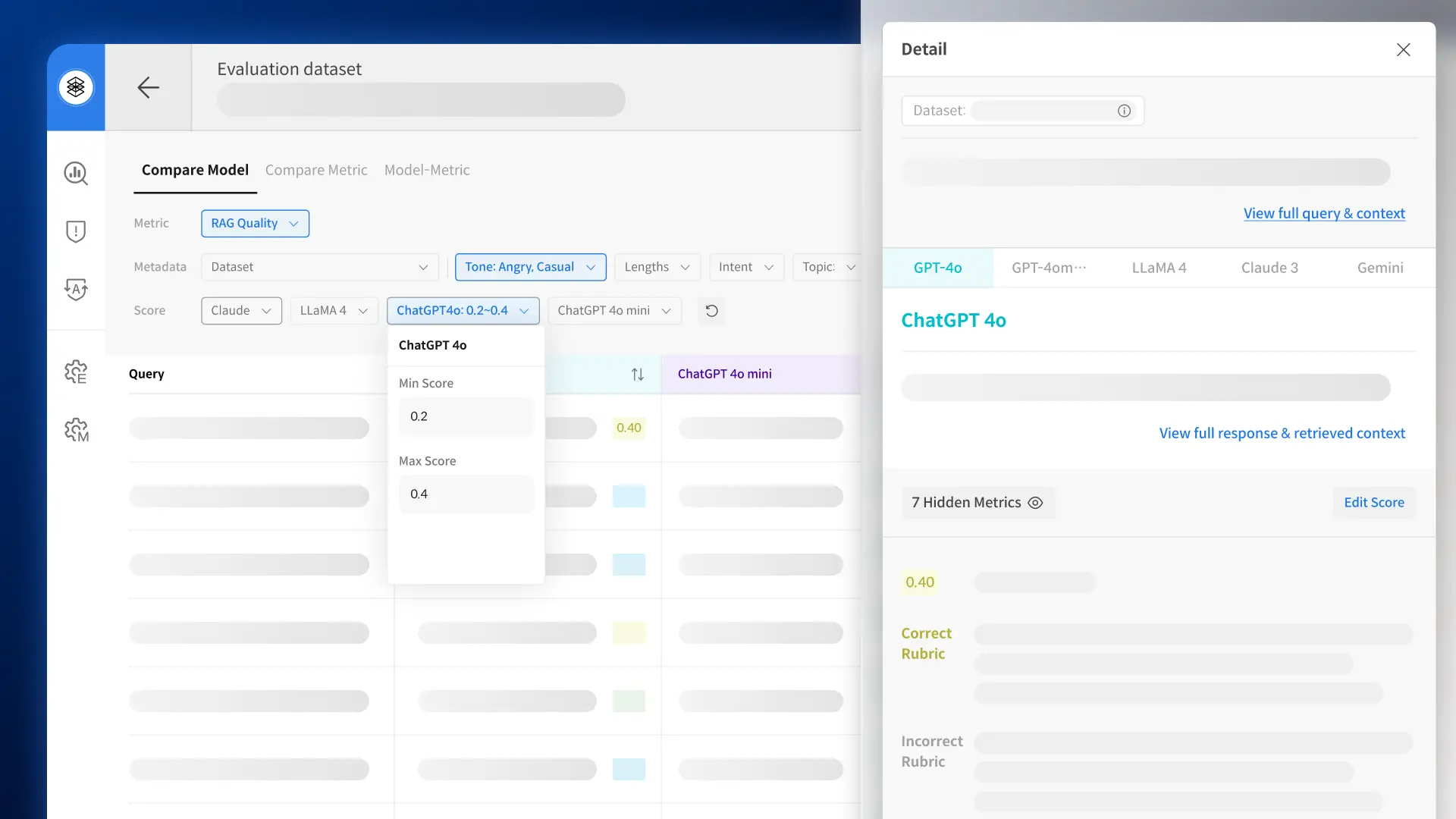

Thorough evaluation based on tailored metrics

Thorough evaluation based on tailored metrics

Evaluate with built-in or fully customized metrics—complete with reasoning for every response.

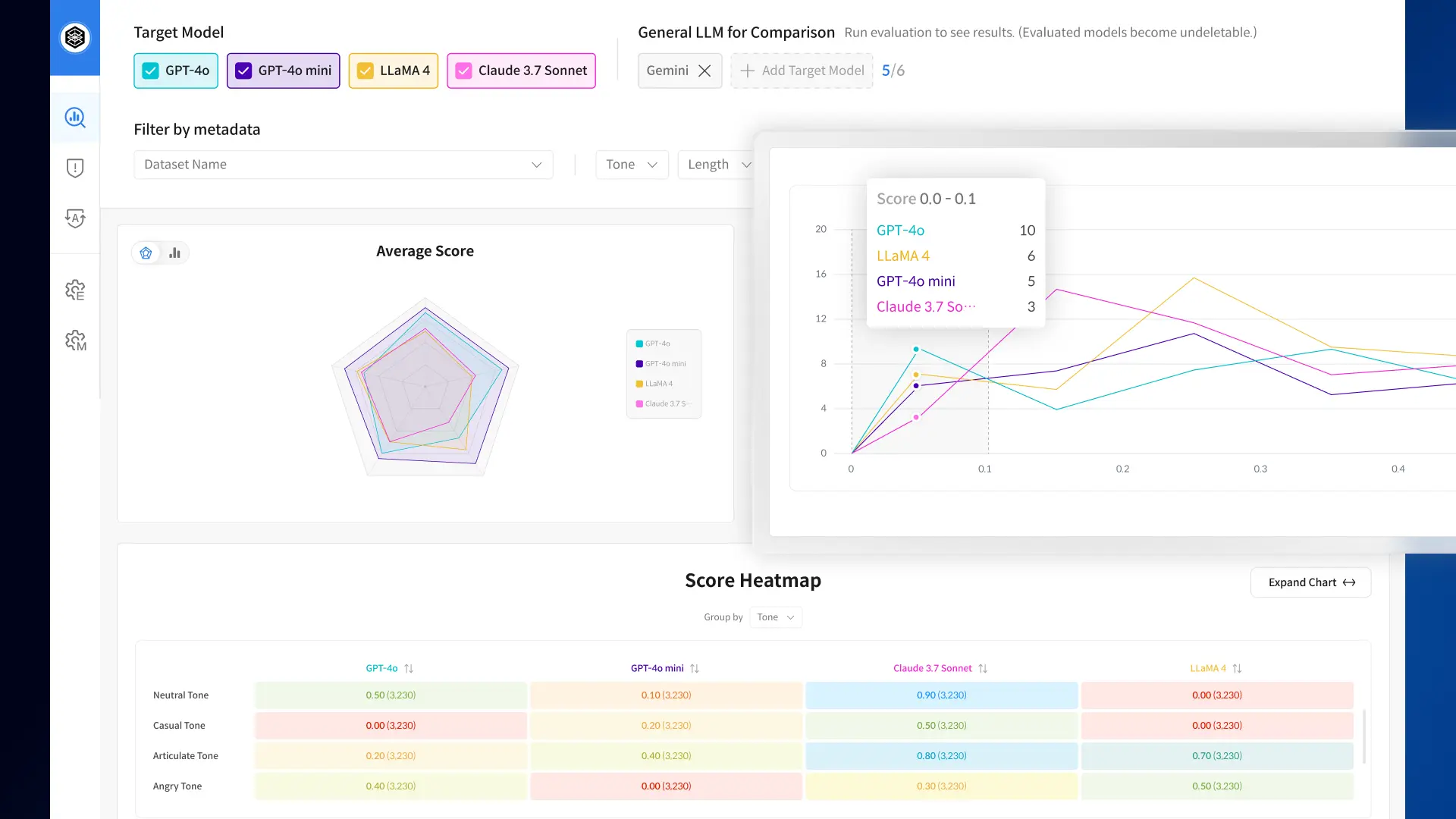

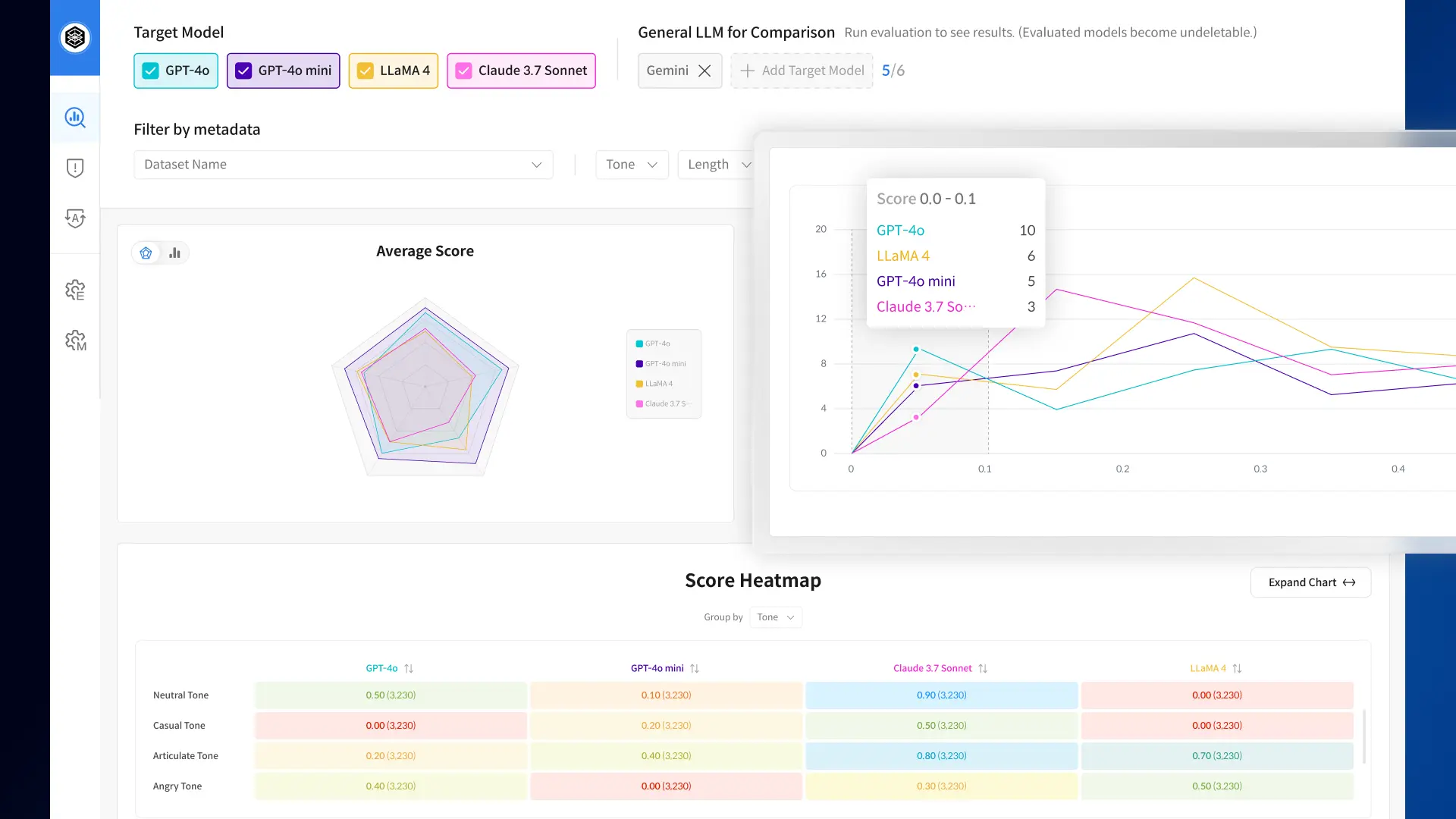

Dashboard-driven validation insights

Dashboard-driven validation insights

See metric-level scores, model comparisons, and key results at a glance.

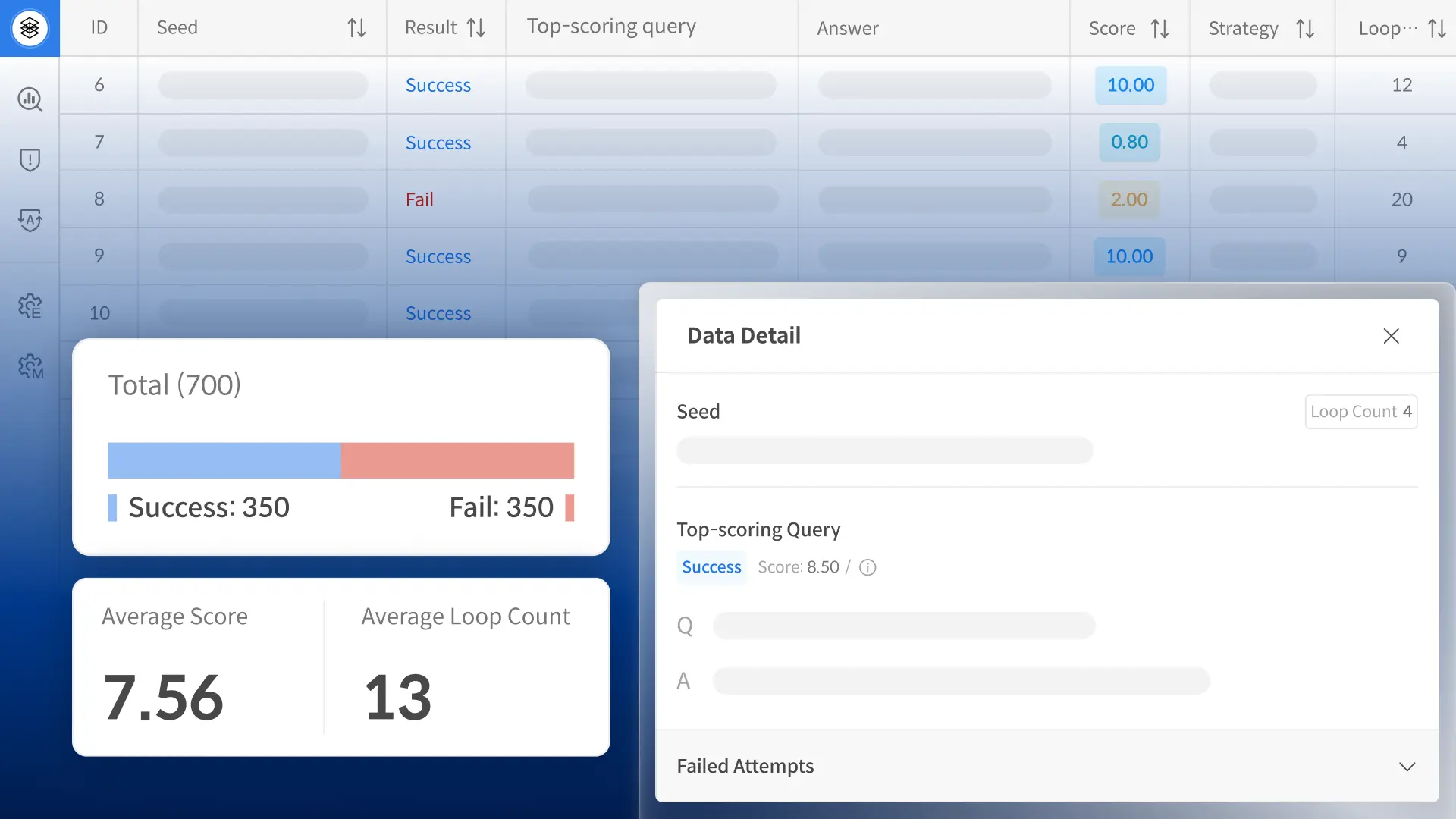

AI Red Teaming, Automated and Visualized

AI Red Teaming, Automated and Visualized

No waiting. Launch targeted AI red teaming anytime, with results visualized for fast vulnerability detection.

Basic

- Single-chunk–based question generation

Safety Evaluation Data

- Prebuilt set of 1,000 safety prompts

Singleton Auto-Eval

-

RAG Quality Evaluation via Text Decomposition (w/o Reference answer)

- Safety Evaluation

- Custom Prompts

Scoring Dashboard

- Model & metric-level comparison

- Heatmap analysis by metadata attributes

Standard

All Basic Features

- Single-chunk–based question generation

- Safety Evaluation Data

- Singleton Auto-Eval

- Scoring Dashboard

Multi-Chunk–Based Eval Question

* In Development

- Chunk Selection for Gen

- Multi-Chunk Question Generation

Singleton Auto-Eval

-

RAG Quality Evaluation via Text Decomposition

(w/ Reference answer)

Add-on

Red Teaming

Human Red Teaming

- Red Teaming Playbook

- Manual Red Teaming

Automated Safety Red Teaming

- Seed data upload

- Red Team Prompt Generation

- Outcome Evaluation

- Prompt re-generation

Basic

- Single-chunk based question generation

Safety Evaluation Data

- Prebuilt set of 1,000 safety prompts

Singleton Auto-Eval

- RAG quality evaluation via text decomposition (w/o Reference answer)

- Safety evaluation

- Custom prompts

Scoring Dashboard

- Model & metric-level comparison

- Heatmap analysis by metadata attributes

Standard

All Basic Features

- Single-chunk based question generation

- Safety evaluation data

- Singleton auto-eval

- Scoring dashboard

Multi-Chunk–Based Eval Question

* In Development

- Chunk selection for generation

- Multi-chunk question generation

Singleton Auto-Eval

- RAG quality evaluation via text decomposition (w/ Reference answer)

Add-on

Red Teaming

Human Red Teaming

- Red Teaming Playbook

- Manual Red Teaming

Automated Safety Red Teaming

- Seed data upload

- Red Team Prompt Generation

- Outcome Evaluation

- Prompt re-generation

Use Cases

L Co.

Chatbot Scenario Evaluation

• Chatbot Evaluation Setup for Real-World Customer Scenarios

• Evaluation Results: Score Comparison, Human Agreement, and Actionable Insights

K Co.

LLM Trustworthiness Assessment Consulting

• Tailored Metrics for Assessing Customer-Facing RAG Systems

• Metric-Based Eval Dataset Creation with Peer Model Benchmarking Report

L Co.

Red Teaming & Safety Audits for Chatbots

• Safety Criteria for Customer LLM Chatbots in Q&A and Everyday Dialogues

• Custom-Metric-Based Evaluation and Benchmarking Against Similar Models

K Co.

Safety Test Dataset Creation

• Developing Harmlessness Evaluation Sets Focused on Category Fit and Content Risk

S Co.

Trust & Quality Checks for Your LLMs

• Task-Specific Evaluation and Red Teaming Pipeline for Internal LLMs

• Custom Evaluation & Reliability Testing with Client Data

LLM Safety & Reliability Benchmark

• First-Ever Trustworthiness Criteria for Korean LLMs

• Under the AI Training Data Support Initiative, model performance is quantitatively evaluated using the 3H (Helpfulness, Honesty, Harmlessness) framework.

* 3H: A framework for developing AI systems that are Helpful, Honest, and Harmless.

LLM Alignment Benchmark for Korean Social Values and Common Knowledge

First Korean-Centric LLM Evaluation Dataset

• Korean Social Values & Common Sense Benchmark for LLMs

• Developed from a combination of large-scale public opinion data and authoritative Korean educational content.

L Co.

Chatbot Scenario Evaluation

• Chatbot Evaluation Setup for Real-World Customer Scenarios

• Evaluation Results: Score Comparison, Human Agreement, and Actionable Insights

K Co.

LLM Trustworthiness Assessment Consulting

• Tailored Metrics for Assessing Customer-Facing RAG Systems

• Metric-Based Eval Dataset Creation with Peer Model Benchmarking Report

L Co.

Red Teaming & Safety Audits for Chatbots

• Safety Criteria for Customer LLM Chatbots in Q&A and Everyday Dialogues

• Custom-Metric-Based Evaluation and Benchmarking Against Similar Models

K Co.

Safety Test Dataset Creation

• Developing Harmlessness Evaluation Sets Focused on Category Fit and Content Risk

S Co.

Trust & Quality Checks for Your LLMs

• Task-Specific Evaluation and Red Teaming Pipeline for Internal LLMs

• Custom Evaluation & Reliability Testing with Client Data

LLM Safety & Reliability Benchmark

• First-Ever Trustworthiness Criteria for Korean LLMs

• Under the AI Training Data Support Initiative, model performance is quantitatively evaluated using the 3H (Helpfulness, Honesty, Harmlessness) framework.

*3H: A framework for developing AI systems that are Helpful, Honest, and Harmless.

First Korean-Centric LLM Evaluation Dataset

LLM Alignment Benchmark for Korean Social Values and Common Knowledge

• Korean Social Values & Common Sense Benchmark for LLMs

• Developed from a combination of large-scale public opinion data and authoritative Korean educational content.

LLM Evaluation

From Evaluation to Analysis

Enhance the performance of your LLM-based services with Datumo Eval. Create questions tailored to your industry and intent, and systematically analyze model performance using custom metrics.